去る2023年には、世界規模で大きな生成AIブームが巻き起こりました。今年は、昨年同様に生成AIが重要視されつつ、より私たちの生活や業務での実用に目が向けられています。ビジネス面では、とくに顧客接点の根本的変革や、カスタマーサクセスの実現という観点で可能性を見いだされています。ChatGPTに代表される生成AIの登場と利活用は、間違いなく世界的なプレ・シンギュラリティとなっています。

すでに一部業務にてChatGPT(その他生成AIを含む)を活用していたり、2024年での本格導入を検討していたりする企業は少なくありません。しかし、情報の正確性や取り扱いの慎重さが求められる法人での生成AI利用は、常にリスクと隣り合わせです。業務の効率化や他社との差別化を目的として生成AIの導入へ踏み切る企業は少なくありませんが、一歩間違うと組織の信用・信頼は大きく低下し、インシデント対応に追われたり顧客離れが起きたりします。

この記事では、生成AIの代表格であるChatGPTを例にして、ChatGPTの法人利用に潜むリスクと、4つの対策を紹介します。

■この記事がおすすめの方

・ChatGPTの法人利用をしたいけど、さまざまなリスクが心配で踏み切れない人

・現在はChatGPTの社内利用を許可しているものの、今度も継続的に利用をするか検討中の人

ChatGPTの法人利用における問題点

個人か法人かに関わりなく、ChatGPTを始めとする生成AIの一般化は目が回る勢いです。そのため、「リスクを犯してまでChatGPTを使うことはしない」という選択肢は現実的でなくなってきています。あくまでChatGPTにはリスクがつきものであることを前提にしつつ、どのようなリスクに対してどんな策を講じるかを決定・実行することが、ChatGPTの安全活用におけるポイントです。

では、ChatGPT活用におけるリスクやデメリットには、具体的にどのようなものがあるでしょうか。現状見られるリスクは以下の通りです。

ハルシネーションによる企業信用度の低下リスク

事実とは異なる内容をもっともらしく出力してくる「ハルシネーション」。現状では、事実と異なる内容や実在しないものを出力してくるケースがあるため、ユーザーがChatGPTからの出力内容を鵜呑みにすることは大変危険です。企業において信用は信頼は全ての基盤となるため、情報の正確性という観点でハルシネーションは命取りになり得ます。

機密情報の漏洩

ChatGPTにおいては、基本的に入力内容がそのままAIの学習へと利用されます。ChatGPTに社外秘のデータや個人情報を入力すると、それが社外サーバーへと保全され、会社とは全く関係のないユーザーへの回答に利用される可能性があります。

※OpenAI社によるプライバシーポリシーでは、ChatGPTにおいてログデータ、利用データ、デバイス情報、クッキー、分析結果を自動取得すると明記されています。

サイバー攻撃への悪用

万能なツールが出てくれば、必ずと言って良いほどそれを悪用する存在が出現します。ChatGPTについても例外ではありません。チェック・ポイント・ソフトウェア・テクノロジーズ株式会社によれば、すでにChatGPTとの関連を装った偽装サイトが急増しており、偽サイトによるマルウェアの配布が見られていると言いますまた、ChatGPTはプログラミングコードを生成することができるので、悪質なマルウェアや攻撃的なコードの生成に悪用される可能性が指摘されています。

▶参考情報:チェック・ポイント・リサーチ、ChatGPTとの関連を装ったウェブサイトの急増を確認

著作権等権利の侵害

ChatGPTが生成するテキストには、既存の著作物に類似したものが混じる可能性があります(現段階でのChatGPTは、著作権違反の可能性を正確に判断することはできません。)。仮に既存の小説やエッセイ、論文の文章をChatGPTがテキスト出力し、ユーザーがそれと気がつかずに利用すると、のちのち企業や個人が権利侵害の責任を問われるリスクがあります。

例として挙げたリスクの中には、すでに大手企業においていくらかの実例が出ています。たとえば、機密情報の漏洩については、2023年の3月に大手企業Samsung Electronicsが社内でChatGPTを活用し、社内の機密情報が少なくとも3件流出してしまっています。ChatGPTの利用を社内に限っていたとしても安心はできません。

とはいえ、無防備に使用するしかないわけではありません。ChatGPTの利活用におけるリスクを正確に把握できていれば、適切な対策を取ることができます。今後は生成AIとの共存がますます求められるので、企業は生成AIと親和性の高い業務環境を整えていく必要があります。「リスクが怖いからChatGPTを始めとした生成AIを使わない」ではなく、「いかにリスクを的確に回避しながら安全に生成AIと共存するか」に考え方をシフトするべきです。

▶参考情報:Samsung、ChatGPTの社内利用で3件の機密漏洩

ChatGPTをより安全に法人利用するための4つの策

先に挙げたChatGPTのリスクの中で、とく情報漏洩については企業側が自衛策をとれる分野です。では、情報漏洩を防ぐべく具体的に何ができるでしょうか。この記事では4つの策を紹介します。

社員に求めるAIリテラシーや企業のセキュリティポリシーを明確にする

ChatGPTの法人利用開始時には、企業が各社員に求めるAIリテラシーや、ChatGPT使用に際してのセキュリティポリシーを策定し、明文化してください。企業における情報漏洩は、悪意のない誤操作(いわゆる「うっかり」)やセキュリティリスクへの意識の低さが原因となりやすいからです。ChatGPTを安全に活用する第一歩は、ChatGPT利活用に潜むリスクを利用者ひとりひとりが正確に把握し、適切なリテラシーをもつことです。

たとえば、情報漏洩に関する以下のようなリスクについて周知徹底できます。

- ChatGPTを活用する中で、悪意のない行為が自社に損害を与える大問題に発展する可能性がある

- ChatGPTに入力した内容は、自分以外の人間(社外も含む)に閲覧される可能性がある

「うっかり」やセキュリティリスクへの認識の低さに起因するインシデントを事前に排除するなら、企業は情報漏洩における一定の自己防衛をはかれます。口頭で伝達するだけでなく、ユーザー向けのマニュアルを作成したり、ChatGPT活用に関する具体的なルールを策定したりすることは有効策です。

たとえば、チャット入力時におけるNGワードの設定や、機密情報および個人情報の入力はしないといったルールの設定です。

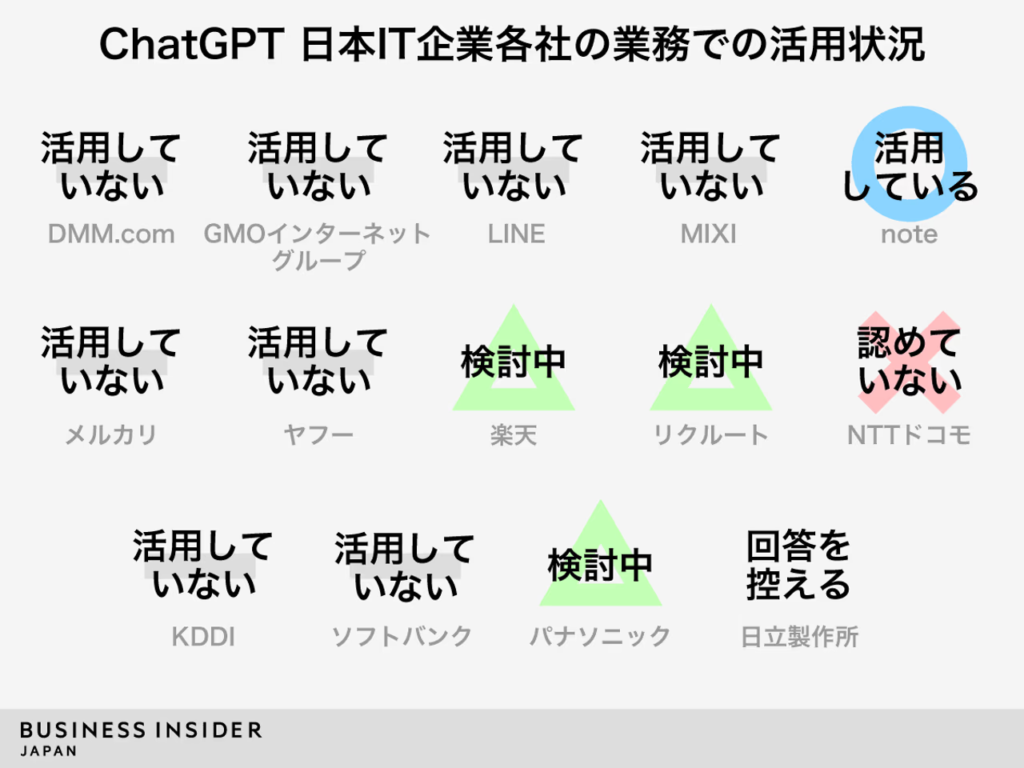

「いくらChatGPTが最新の技術とはいえ、自社の社員には最低限のネットリテラシーがあるので、マニュアル作成やルールの策定は大袈裟ではないか」と思われるでしょうか。Tech Insiderは、ChatGPTの利用に関して国内のIT・デジタル企業14社に以下のようなアンケートを実施しました。

- ChatGPTを業務で活用しているか

- ChatGPTを業務で使用する場合、ガイドラインが存在するか(ある場合はその概要)

- 業務で使用しているChatGPT以外の生成系AIはあるか

意外なことに、アンケートを実施した14社の中では、ChatGPTを含む生成AIに限定した明確なガイドラインを策定している企業は存在しません。しかし、14社中5社は、「外部のクラウドサービスなどに関する利用規定の適用やセキュリティチェックを実施する」と回答しています。その他の企業においても、「従来のルールで良いのかを確認するべき」だと回答しています。

たしかにネットリテラシーとAIリテラシーには通じるものがあります。しかし決して同一のものではありません。すでに各社員が高いネットリテラシーを持っていると見受けられたり、既存のルールがしっかり定まっていたりするとしても、対生成AI用に整え直す必要があります。「うちは大丈夫」の考えが、まさにChatGPTの利活用に根源的に潜むリスクです。

ぜひ、策定した内容を定期的に見直し、自衛できる分野でのセキュリティ力を常に高めていきましょう。

ChatGPT Enterprise/法人向けプラットフォームを活用する

情報漏洩を含め、ChatGPTを法人利用する際にぶつかる壁はどの企業も同じです。共通するセキュリティニーズに対してOpenAI社が2023年8月にリリースしたのが、法人向けChatGPTである「ChatGPT Enterprise」です。

ChatGPT Enterpriseでは、その名の通り法人向けに機能やセキュリティがアップデートされています。セキュリティについては以下のような仕様となっています。

- 入力内容はOpenAIモデルのトレーニングに使用不可

- データを暗号化(AES256・TLS 1.2+使用)

- SOC2に準拠

また、ChatGPT Enterpriseには管理コンソールが導入されており、ユーザーの追加・削除、利用状況の確認などが行えるようになっています。この機能によりシステム管理者の負担が軽減されるだけでなく、組織としてより安全にChatGPTを活用できるようになるのです。

ChatGPT Enterprise の他には、ChatGPTの法人向けプラットフォームを活用するという選択肢があります。法人向けプラットフォームを利用すると、個人や組織でのChatGPT利用状況が把握できたり、機密性の高い情報を検知・制限・禁止することができたりします。

ChatGPTの法人向けプラットフォームの例:

・法人GAI

・行政向け“安全な”ChatGPT「Crew」

インシデント対応プロセスの整備

全てのリスクを完璧に排除しつつChatGPTをフル活用することこそが私たちの理想です。ここまで紹介してきたように、ある程度はユーザー側の策によってリスク回避や軽減に取り組むことができます。しかし、時にはサービス提供者側のトラブル(ハッキングや不正アクセスなど)によってインシデントが起きることがあります。

「100%リスクとトラブル無しで安心利用ができる」との考え方は非現実的です。そのため、万が一のときに被害を最小限にとどめるための策を講じておくことは必要不可欠です。たとえば、インシデント対応のチーム発足や対応プロセスの整備などは、ChatGPT導入の時点で必ず行っておきましょう。この点で「用意周到すぎる」ということはありません。

ChatGPTに関する社員教育を行う

繰り返しとなりますが、ChatGPTの利活用におけるリスクを正確に把握できていなければ、的確なリスク回避を行うこともその理由もわかりません。「リスクを知らない」ということこそが一番のリスクです。

最近ではAIリテラシーを築くためのセミナーや本などが急増しています。社内でのChatGPTに関する社員教育は必要ですが、社外のサービスや商品を使って、自社の守備をより広く強いものにすることは有用な策です。

さまざまな技術やノウハウによってChatGPTのリスクを軽減することは可能です。しかし、最終的なセキュリティ力はユーザー自身にかかっています。そのため、ChatGPTを安全に使いこなす人的環境を整えていくことこそが、企業にとっての最大のリスクヘッジとなります。

最後に

ChatGPTは業務を効率化するのに役立つツールです。新しい技術だからこそ、リスクに対する恐怖や、いわゆる失敗例が取り沙汰されます。かと言って、「リスクが怖いから使わない」「社内におけるChatGPTの使い方をがんじがらめに制限して、法人としての利用リスクをとにかく0にしなくてはいけない」というスタンスではいずれ限界を迎えてしまうでしょう。

リスクを正確に把握し、自社や他社の成功例・失敗例を受け止め、常に的確なリスク対策を講じるならChatGPTを始めとした生成AIをセキュアで安心して活用することは可能です。プレ・シンギュラリティに立つ私たちは、事前に自己防衛できる範囲を徹底することで、より安心安全にChatGPTを使いこなし、業務の効率化に役立てたいものです。